L es développements de l’IA semblent s’accélérer : Microsoft a annoncé dernièrement investir 10 milliards de dollars dans OpenAI qui qui a créé le populaire module de conversation ChatGPT .

Tom Kehler travaille dans le domaine de l’intelligence artificielle depuis plus de 40 ans, en tant que codeur et PDG. Fils de prédicateur, il s’est intéressé à la linguistique mathématique au lycée. Après avoir obtenu un doctorat en physique, il voulait faire de la linguistique avec Wycliffe Bible Translators, mais « Dieu n’a cessé de fermer cette porte » et Tom s’est retrouvé à travailler sur le traitement du langage naturel en informatique.

Il a fait un passage dans le monde universitaire avant de rejoindre Texas Instruments en 1980, où il a commencé à travailler avec les meilleurs chercheurs en IA. Il s’est retrouvé dans la Silicon Valley, où il a fondé et dirigé plusieurs startups spécialisées dans l’IA, dont IntelliCorp et CrowdSmart.

Un des meilleurs chercheurs d’OpenAI a récemment décrit les réseaux neuronaux actuels comme étant « légèrement conscients ». Tom Kehler a des doutes.

Quelles étaient les questions relatives à l’IA dans les années 1980, lorsque vous avez commencé à y travailler ?

« Est-ce que ça va remplacer mon travail ? » Dans de nombreux cas, la réponse est oui. Nous devons penser à la formation continue — vous ne travaillerez peut-être plus sur la chaîne de montage, mais vous pourriez faire fonctionner les machines qui la constitueront. L’autre question récurrente est cette notion de singularité [lorsque le développement de l’IA échappera à l’être humain]. Il y a aussi la question de la capacité à ressentir. Mais je pense que nous en sommes très loin.

Pourquoi l’idée d’une IA capable d’émotions est-elle si importante ?

Si vous êtes non croyant, il est tentant de vouloir créer quelque chose qui vous donne de l’espoir dans l’avenir. Pour ce qui est de l’IA, nous aimerions quelque chose qui nous permette d’envisager une forme de vie éternelle : ma conscience projetée dans l’éternité, parce que contenue dans une machine. Je pense que cela motive certaines de ces idées d’IA généralisée à toute la vie, comme l’obsession de la singularité de [Ray] Kurzweil. Ce phénomène nous en dit davantage sur le désir humain que sur la situation dans laquelle nous nous trouvons en matière de progrès.

Que pensez-vous de l’ingénieur de Google qui, l’année dernière, affirmait que son « chatbot » était devenu conscient et avait une âme ?

Je pense qu’il a passé trop de temps avec son ordinateur portable, honnêtement. Nous travaillons avec le même type de grands modèles de langage (large language models). C’est ce qu’on appelle les transformeurs (transformer models). Toute ma carrière, je me suis concentré sur le traitement du langage naturel, un domaine qui existe depuis un certain temps déjà. Tous ces modèles ont été construits en agrégeant des informations provenant de sites comme Wikipédia. Ils sont l’écho de l’intelligence humaine.

Pour que ces systèmes arrivent à dire, par exemple, « C’est le numéro sept », on travaille à les renforcer jusqu’à ce que le réseau neuronal puisse reconnaître ce sept. Ce travail de corrélation d’éléments est au cœur du fonctionnement de l’IA aujourd’hui.

Voici ce qui m’impressionnerait davantage : partir d’un système vide, et que celui-ci ait la capacité d’apprendre le langage à la vitesse d’un enfant. La façon dont les enfants acquièrent le langage est vraiment époustouflante. Et pas seulement la langue, mais même la manière dont vous ouvrez la porte d’un placard. Ils voient quelque chose une fois, et ils trouvent comment le faire.

Le système dont parlait cet ingénieur de Google a reçu des milliards d’exemples afin d’en tirer une certaine intelligence. Il consomme des quantités astronomiques d’énergie, alors que le cerveau d’un petit enfant a besoin de la puissance d’une lampe de poche, et est capable d’apprendre le langage. Nous ne sommes pas du tout proches de ce type d’IA forte (general AI).

Nous sous-estimons l’étendue de notre ignorance du fonctionnement du cerveau. Et nous avons une confiance excessive dans les outils à notre disposition jusqu’à présent. [L’informaticien] Judea Pearl, dans The Book of Why, explique que l’apprentissage profond (deep learning) nous permet d’atteindre des niveaux d’intelligence animale, avec une corrélation avec les entrées et les données. Cela devient très intéressant. C’est ce qui nous permet d’avoir des choses assez intéressantes comme des bateaux qui peuvent traverser l’océan sans pilote. Ce que nous pouvons faire avec l’IA est incroyable, mais ce n’est pas la même chose que de dire que nous serions maintenant face à un être intelligent.

Où souhaiteriez-vous que l’IA aille ?

Il est scientifiquement prouvé que les problèmes que nous devons aujourd’hui résoudre sont bien trop complexes pour une seule personne. Nous devons utiliser l’intelligence collective pour trouver comment résoudre certains de ces grands problèmes. Je pense que l’IA pourrait être un énorme avantage, plutôt qu’une menace, pour le développement humain.

Que pensez-vous de ChatGPT, ce nouveau module de conversation (chatbot) populaire ?

Il propose sous une forme accessible des connaissances qui ont été acquises depuis très longtemps. C’est un utilitaire très intéressant si vous lui posez des questions de connaissances générales, comme une encyclopédie. Il présente l’information sous une bien meilleure forme que ce que vous obtenez en effectuant une recherche où vous aboutissez à une série de liens et où vous devez reconstituer l’histoire vous-même.

Mais vous pensez qu’il a aussi des problèmes.

Il se contente de recevoir les informations pour construire ses connaissances. Il ne vérifie pas la vérité ou, comme on le dit dans les systèmes d’information, la lignée des données (data lineage). D’où viennent ces données ? Est-ce que l’on sait que c’est vrai ? ChatGPT traduit simplement un texte d’entrée en texte de sortie en fonction d’un certain objectif.

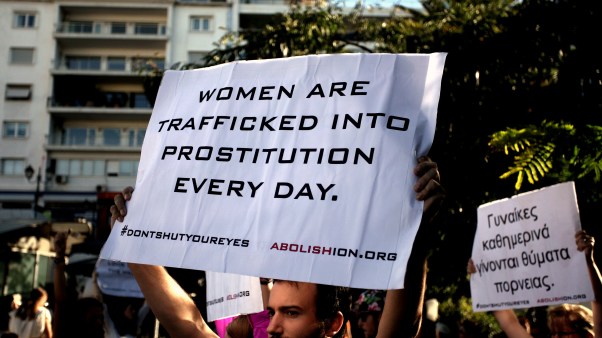

Imaginons que vous utilisiez ChatGPT pour entreprendre une action ou prendre une décision. Ce qui s’est passé au cours des six ou sept dernières années, c’est que l’IA a été utilisée pour manipuler l’opinion des gens. Il y a eu des campagnes pour imiter la vérité, tout en la déformant.

C’est aussi quelque chose que l’on peut faire avec un outil comme ChatGPT. Vous ne pouvez pas l’utiliser comme nous utiliserions la science, lorsque par exemple nous prenons une décision pour créer un médicament. Il doit y avoir un processus humain pour savoir si les données sont dignes de confiance ou non.

Comment créer un outil digne de confiance ?

Si l’on se réfère à la façon dont les connaissances scientifiques ou médicales ont été développées, c’est par l’examen par les pairs. En tant qu’humains, nous avons considéré cette procédure comme digne de confiance. Elle n’est pas parfaite. Mais c’est comme ça qu’on établit normalement la confiance. Si 12 des meilleurs chirurgiens cardiaques du monde disent qu’une certaine procédure est bonne, vous en conclurez qu’elle est bonne. Si c’est ChatGPT qui vous a dit de suivre une procédure, vous feriez mieux de la faire réviser par quelqu’un, car elle pourrait être erronée.

Je pense qu’il est essentiel, d’un point de vue éthique, que nous gardions les humains dans la boucle du développement des technologies d’intelligence artificielle. Nous avons vu que les systèmes d’IA peuvent battre quelqu’un aux échecs, mais c’est juste un ensemble de compétences. Cela ne prouve pas qu’on peut leur faire confiance pour ce que nous, les humains, appelons la sagesse : comment vivre.

Pourquoi la véracité de ces outils est-elle importante pour les chrétiens ?

La foi touche à l’assurance des choses que l’on espère. Quand les gens pensent que la foi est juste un saut dans le vide, ce n’est pas vrai. Nous prenons des décisions de foi en fonction d’éléments véridiques.

Voyez ce qui s’est passé dans le christianisme suite à la désinformation. N’est-ce pas cela qui a causé tant de fragmentation ? Certains ont par exemple commencé à répandre les théories de QAnon. Des informations sont propagées alors que leur valeur réelle n’a pas été déterminée. Cela provoque des divisions dans les familles.

Nous devons nous concentrer sur ce qui est vrai. Je pense au cadre donné par la lettre aux Philippiens : ce qui est vrai, ce qui est bon, ce qui crée un plus grand bien commun. C’est le plan originel du christianisme, l’émergence du royaume de Dieu.

La conviction que nous pouvons essayer de trouver un accord et nous rassembler est au cœur même de ce que j’espère pour l’intelligence artificielle. C’est un principe scientifique : nous nous appuyons sur des évidences étayées par les pairs auxquelles nous faisons confiance et qui font avancer la science.

Vous avez affirmé que certains modèles mathématiques eux-mêmes aident à construire une IA plus fiable.

Tous les ingénieurs en IA de la planète connaissent les applications bayésiennes, car elles sont fondamentales pour la plupart des IA contemporaines. L’apprentissage bayésien trouve ses racines chez un pasteur presbytérien des années 1700.

La pensée bayésienne demande : « Comment les preuves changent-elles mes croyances ? » Je forme de nouvelles croyances basées sur des preuves. Vous pouvez utiliser des modèles bayésiens pour construire des types de systèmes intelligents beaucoup plus riches, et vous pouvez faire en sorte qu’ils soient explicables. Le modèle peut vous dire comment il a obtenu une réponse.

Les gens de la Silicon Valley qui croient vraiment à la singularité — que c’est la façon dont nous allons atteindre la vie éternelle — ne réalisent pas qu’une grande partie des fondements de tout cela ont été établis par des gens qui avaient une foi profonde en Dieu. Je trouve cela à la fois intéressant et amusant.

Avez-vous utilisé ChatGPT ?

Je lui ai demandé de décrire la façon dont les grands modèles linguistiques vont détruire la société humaine telle que nous la connaissons. Et il explique très bien la chose.

C’est un chef-d’œuvre de technologie. Je n’essaie pas de le nier, mais de dire : « Voilà jusqu’où vous pouvez aller avec ça. » Et j’ai un problème éthique plus profond : il me paraîtrait un peu dangereux de commencer à présupposer que la machine est d’une intelligence supérieure à celle de l’homme, surtout si cela ne repose sur aucun fondement éthique.

Je ne voudrais pas d’un automate qui commence à faire des choses sans que l’on sache pourquoi ou comment il les fait. L’explicabilité est très importante. Il n’y a probablement pas assez de prise de hauteur dans la réflexion sur les directions dans lesquelles tout cela nous mène et l’influence que nous voulons y exercer. Nous avons besoin de personnes qui réfléchissent en profondeur aux implications spirituelles de ces choses.

–